PIM(Process In Memory)

인간의 두뇌처럼 데이터 저장(메모리)과 연산(시스템)을 동시에 수행하는 새로운 개념의 메모리 반도체. 메모리와 중앙처리장치(CPU)가 별도로 있는 기존 반도체와 비교할 때, 데이터 이동 거리가 짧아 에너지 소비가 줄고 성능도 향상된다. 삼성전자는 PIM 기술을 활용해 2021년 수퍼 컴퓨터(HPC)와 인공지능(AI) 분야 등에 활용되는 고대역폭 메모리(HBM)-PIM을 세계 최초로 개발했다

삼성전자, 신개념 메모리 'PIM'으로 반도체 시장 정조준

삼성전자가 고대역폭 메모리(HBM)를 뛰어넘을 차세대 인공지능(AI) 반도체로 지능형 메모리 반도체 PIM(Process In Memory) 등을 집중 개발한다. PIM은 데이터 저장(메모리)과 연산을 동시에 수행할 수 있는 새로운 개념의 반도체다. 또 가전과 모바일에 온디바이스(내장형) AI 기능을 탑재해 AI 생태계를 구축하기로 했다. 삼성전자는 지난 4일부터 이틀간 요슈아 벤지오 캐나다 몬트리올대 교수 등 글로벌 인공지능(AI) 석학들과 함께 ‘삼성 AI 포럼 2024’를 열고 삼성의 AI 전략에 대해 집중 논의했다. 한종희 대표이사(부회장)는 개회사에서 “AI는 놀라운 속도로 우리의 삶을 변화시키고 있고 앞으로 ‘어떻게 AI를 더 책임감 있게 사용할 수 있을지’가 갈수록 중요해지고 있다”며 “삼성전자는 보다 효율적이고 지속 가능한 AI 생태계를 구축하는 데 책임을 다할 것”이라고 밝혔다.

HBM 이후 차세대 AI 반도체 PIM

삼성전자는 이번 포럼에서 HBM 이후 차세대 AI 반도체로 ‘PIM 반도체’ 등을 추진하기로 했다. HBM은 데이터센터에 들어가는 AI 가속기의 핵심 부품이지만, 삼성전자는 경쟁력에서 한발 뒤처져 있다. 삼성전자는 HBM 경쟁력 회복과 동시에 완전히 새로운 개념의 AI 반도체로 시장을 뒤집겠다는 전략이다. 삼성전자가 내세운 PIM은 데이터 저장(메모리)과 연산을 동시에 한다. AI 반도체의 최대 난제인 전력 소모를 대폭 줄일 수 있다. 삼성전자는 2021년 HBM 메모리 내부에 시스템 반도체인 AI 프로세서를 집어넣은 HBM-PIM 반도체를 세계 최초로 개발했다.

이번 포럼에서 손교민 삼성전자 마스터는 “현재 AI 반도체의 핵심 구성 요소로 부각되고 있는 HBM의 경우 대역폭을 높이고 단을 계속 올리는 것이 쉽지 않을 것”이라며 “이를 해결할 수 있는 새로운 설루션인 PIM이 다음 AI 메모리로 유력하게 거론되고 있다”고 말했다. 그는 또 “HBM이 1번 주자인 것은 확실하지만 우리가 현재만 바라보고 갈 수는 없다”며 “미래를 보며 PIM 등 다양한 설루션을 집중적으로 연구하고 있다”고 말했다.

이날 삼성전자는 미국 반도체 회사 AMD와의 협력도 강조했다. AMD는 AI 반도체에서 엔비디아의 대항마로 꼽힌다. 현재 삼성전자는 AMD에 5세대 HBM인 HBM3E를 공급하고 있는 것으로 알려졌다. 이번 포럼 기술 세션에 AMD의 조셉 마크리 CTO(부사장)가 연단에 올라 ‘어디에나 존재하는 AI’를 주제로 강연했다. 이 자리에서 마크리 부사장은 AMD의 AI 설루션을 소개하고 AI 플랫폼과 협업의 중요성, AMD의 강점 등을 발표했다.

“AI 일상화되는 미래 홈 선점”

삼성전자는 반도체뿐 아니라 모바일, TV, 가전 등 모든 제품에 AI 기술을 적용해 ‘AI 일상화’를 이끈다는 계획이다. 종합 IT 회사라는 장점을 십분 활용해 제품을 연결하고 이를 통해 더 개인화된 AI 경험을 구현할 수 있다는 것이다. 삼성전자는 지난달 31일 3분기 실적 발표에서 공개한 ‘멀티 디바이스 AI 전략’에서 3억6000만명의 사용자를 확보한 삼성전자의 가전 플랫폼 ‘스마트싱스’를 기반으로 “AI가 일상화되는 미래 홈을 선점하겠다”고 밝혔다.

올해 포럼에는 세계 최고 AI 석학으로 꼽히는 요슈아 벤지오 캐나다 몬트리올대 교수와 지식 그래프 분야 권위자인 이안 호록스 영국 옥스퍼드대 교수가 직접 한국을 찾아 기조 강연에 나섰다. 이 밖에 얀 르쿤 메타 수석 AI 과학자도 화상으로 관람객들을 맞았다. 벤지오 교수는 4일 기조 연설에서 AI의 성능이 다양한 분야에서 인간 수준을 넘어섰다는 연구 결과를 소개했다. 그는 “AI 안전을 위해서는 정책 입안자들은 물론 대중들도 AI의 현재 상태와 미래에 대해 정확히 이해하고 있어야 한다”며 “AI의 안전성을 확보하기 위해 안전한 AI 설계 등이 반드시 필요하다”고 강조했다.

What is processing in memory?

Processing in memory, or PIM (sometimes called processor in memory), refers to the integration of a processor with Random Access Memory (RAM) on a single chip. The result is sometimes known as a PIM chip.

PIM allows computations and processing to be performed within the memory of a computer, server or similar device. The arrangement speeds up the overall processing of tasks by performing them within the memory module.

How processing in memory works

Standard computer architectures suffer from a latency problem. This latency is also known as the von Neumann bottleneck and is the result of all processing being done by the processor alone. The computer's memory is not involved in processing, as it is used only to store programs and data. PIM is one approach to overcome this inherent latency issue.

In a computing system or application, when the volume of data is large, moving it between memory and processors can slow down processing. Adding processing directly into memory can help alleviate this problem. PIM can manipulate data entirely in the computer's memory. The application software running on one or more computers manages the processing and the data in memory.

If multiple computers are involved, the software divides the processing into smaller tasks. These tasks are then distributed to each computer and run in parallel to reduce latency and speed up processing.

Difference between processing in memory and database processing

Database processing refers to relational database management systems (RDBMS) structured to allow the use of query languages like SQL. With RDBMS processing, the data is first loaded from the disk so that it can be processed.

If data volumes are large, processing may slow down as data has to be swapped in and out of memory, which could also hamper overall computing performance. Processing in memory can increase RDBMS processing speeds by loading data directly onto the RAM or flash memory that also has computational capabilities.

Another difference between the two methods concerns the use of databases. Database processing is optimized for row-based databases, while PIM depends on column-centric databases. Row-based storage is suitable for transactional processing, but not for applications like business intelligence (BI), where column-based databases are more suitable. This is why PIM is so useful for such applications.

PIM(Processing-In-Memory)

SK하이닉스가 생성형 인공지능(AI)에 사용되는 최신 AI 가속기를 내놨다. 초거대 AI 분야 맞춤형 메모리 솔루션을 앞세워 AI 반도체 시장을 공략한다는 계획이다.

14일 업계에 따르면 SK하이닉스는 지난 12일(현지시간) 미국 샌타클래라주에서 개최된 'AI 하드웨어 & 엣지 AI 서밋 2023'(AI Hardware & Edge AI Summit 2023)에 참가해 'AiMX'라는 이름의 프로토타입(시제품)을 처음 선보였다. AiMX는 AiM으로 구동되는 AI 가속기다.

AiM(Accelerator in Memory)은 지능형 메모리로 불리는 ' #PIM ( #프로세싱인메모리 )을 접목한 SK하이닉스 제품이다.

PIM은 프로세서가 수행하는 데이터 연산 기능을 메모리 내부에 구현한 기술로 챗GPT와 같은 AI 모델이 점차 진화하고, 파라미터(외부로부터 투입되는 데이터) 사이즈가 더 커지면서 더욱 각광받고 있다.

특히 PIM을 활용하면 CPU(중앙처리장치)와 메모리 간 데이터 이동이 줄어들어 AI 가속기 시스템의 성능과 에너지 효율을 높일 수 있다. 초거대 AI에서 기존 방식으로는 CPU에 부하가 걸리거나 데이터 처리 속도가 급격히 떨어질 수 있는데 PIM이 이를 해결할 수 있다는 설명이다.

SK하이닉스는 그래픽 D램인 GDDR에 PIM을 붙이는 방식으로 제품 연구·개발을 추진하고 있다.

지난해 2월에는 PIM이 적용된 첫 제품 'GDDR6-AiM'을 개발했다. GDDR6-AiM CPU·GPU(그래픽처리장치) 등 프로세서 연산 기능을 대신한다. 특정 연산의 속도가 최대 16배까지 빨라지고 기존 제품 대비 에너지 소모를 80%가량 줄여준다.

한편 이날 공개된 AiMX는 GDDR6-AiM이 콘트롤러에 통합된 형태다. AI·빅데이터 기반 서비스 품질 향상에 기여할 수 있을 것으로 전망된다.

SK하이닉스는 "이번 행사에서 AiMX를 사용해 생성형 AI 서비스 지연 시간과 에너지 소비를 줄이는 방법을 발표했다"며 "올해 생성형 AI를 가속하도록 설계된 카드 폼팩터 솔루션인 AiMX의 도입을 위한 최종 준비도 완료했다"고 밝혔다.

SK하이닉스가 자체 데이터 연산 기능을 갖춘 차세대 메모리반도체를 개발하고, 해당 기술을 적용한 첫 제품을 선보였다. SK하이닉시는 이를 기반으로 머신러닝, 고성능 컴퓨팅 등 관련 메모리 솔루션 시장에 진출...

SK하이닉스가 자체 데이터 연산 기능을 갖춘 차세대 메모리반도체를 개발하고, 해당 기술을 적용한 첫 제품을 선보였다. SK하이닉시는 이를 기반으로 머신러닝, 고성능 컴퓨팅 등 관련 메모리 솔루션 시장에 진출할 계획이다.

PIM는 메모리반도체에서 자체적으로 데이터 연산을 할 수 있도록 만드는 기술이다. 메모리반도체에 데이터를 저장하고 CPU, GPU 등에서 데이터를 연산하던 기존 방식보다 데이터 처리 속도, 효율성이 뛰어나다는 장점이 있다.

SK하이닉스는 이달 말 미국 샌프란시스코에서 열리는 반도체 분야 세계 최고 권위 학회인 '2022 ISSCC'에서 PIM 개발 성과를 공개할 예정이다. 회사는 향후 이 기술이 진화하면 스마트폰 등 ICT 기기에서 메모리반도체가 중심적인 역할을 하는 '메모리 센트릭(Memory Centric) 컴퓨팅'도 가능해질 것으로 기대하고 있다.

이와 함께 SK하이닉스는 PIM이 적용된 첫 제품으로 'GDDR6-AiM(Accelerator in Memory)' 샘플을 개발했다. 초당 16기가비트(Gbps) 속도로 데이터를 처리하는 GDDR6 메모리에 연산 기능이 더해진 제품이다. 일반 D램 대신 이 제품을 CPU/GPU와 함께 탑재하면 특정 연산의 속도는 최대 16배까지 빨라진다. 앞으로 GDDR6-AiM은 머신러닝(Machine Learning), 고성능 컴퓨팅, 빅 데이터의 연산과 저장 등에 활용될 전망이다.

특히 이 제품은 #GDDR6 의 기존 동작 전압인 1.35V보다 낮은 1.25V에서 구동된다. 또 자체 연산을 하는 PIM이 CPU/GPU로의 데이터 이동을 줄여 CPU/GPU에서 소모되는 전력을 줄여준다. 그 결과 기존 제품 대비 에너지 소모는 80% 가량 줄어든다.

이외에도 SK하이닉스는 최근 SK텔레콤에서 분사한 AI 반도체 기업인 사피온(SAPEON)과 협력해 GDDR6-AiM과 AI 반도체를 결합한 기술도 선보일 계획이다. 사피온 류수정 대표는 "인공 신경망 데이터 활용이 최근 급속도로 늘어나 이러한 연산 특성에 최적화한 컴퓨팅 기술이 요구된다"며 "양사의 기술을 융합해 데이터 연산, 비용, 에너지 사용 측면에서 효율성을 극대화할 것"이라고 밝혔다.

PIM : 연산 반도체 역할의 일부를 가져오다

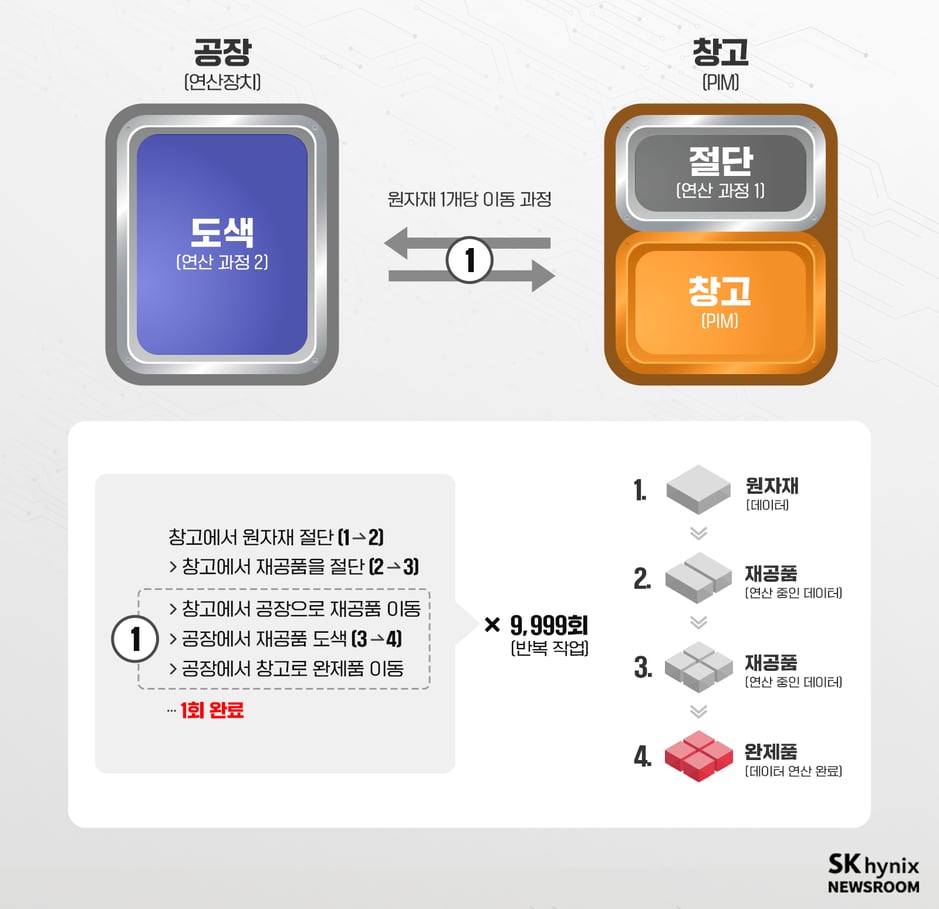

우리는 메모리와 연산용 반도체(GPU, CPU 등)는 창고와 공장과 같고 이는 도로로 연결된 것과 같다는 것을 앞서 살펴봤다. 하지만 사실 이 안에는 컴퓨터 프로그램이 가지는 중요한 요소가 빠져있다. 바로 ‘연산용 반도체는 중간 결과물을 메모리에 저장해야 한다’는 것이다. 이는 실제 공장과는 달리 재료가 한번 들어오면 완제품이 만들어지는 구조가 아닌 제조 공정 단계별로 생산되는 재공품(생산과정 가운데 있는 미완성품)을 창고에 보관했다가, 가공하기 위해 다시 가져오는 것과 같다.

<그림 1>는 메모리와 연산 반도체 사이에 발생하는 데이터 처리 과정을 가상의 공장(연산 반도체)과 창고(메모리)의 모습으로 설명한 예시이다. 공장이 원자재 완제품으로 만들기(데이터 처리) 위해서는 절단과 도색 두 가지 작업이 필요하다. 여기서 공장의 역할은 절단과 도색 두 가지 작업을 하는 것이지 원자재와 재공품을 보관하는 것이 아니다. 때문에 절단과 도색을 할 때 마다 창고에서 원자재와 재공품을 가지고 오고, 다시 가져다 놓는 일을 반복해야 한다. 이런 이동은 번거롭고 시간이 많이 소요된다. 때문에 공장에 작은 선반 같은 것을 두고 임시로 원자재와 재공품을 보관하면 더 빠르고 편해질 것이다. 여기서 말한 선반이 바로 캐시메모리의 역할이다.

여기서, 공장의 효율적인 생산, 즉 연산장치와 메모리를 통한 인공지능 동작 성능을 높이려면 어떻게 해야 할까? 메모리의 동작 속도를 높이는 방법이나 재공품 선반(캐시메모리)의 크기를 키우는 방법이 있을 것이다. 하지만 전자의 경우, 앞서 이야기 했듯 동작 속도의 성능 향상의 한계로 인해 어려움이 있다. 또한, 후자의 경우, 지금도 캐시메모리는 동일 용량의 D램보다 10배 이상 많은 면적을 차지하기 때문에 매우 비효율적이다.

그렇다면, 여기서 한 가지 아이디어가 떠오른다. ‘자주 해야 하는 작업에 필요한 물건은 굳이 공장으로 옮기지 않고, 이를 창고에서 바로 처리한다면 효율이 오르지 않을까?’라는 것이다. 이렇게 해서 등장한 아이디어가 바로 PIM(Processing-In-Memory)이다.

<그림 2>는 <그림 1>에서 메모리를 PIM으로 변경했을 경우의 데이터 처리 과정이다. 두 그림을 비교해 보니 PIM이 왜 필요한지 좀 더 명확하게 보인다. 데이터 전송은 연산 과정에서 상당 부분을 차지한다. 그래서 메모리 반도체 회사들은 처음부터 메모리 반도체에서 연산용 반도체로 데이터를 전송할 필요 없도록 방법을 찾은 것이다. PIM을 사용하면, 메모리 반도체의 데이터 전송 과정이 줄어들고 이로 인해, 데이터 처리 속도가 상당히 향상될 뿐만 아니라, 전성비(전력 대비 성능비)도 매우 높아진다. PIM은 인공지능 등이 요구하는 각종 연산을 메모리에 내재화해 전체적인 성능뿐 아니라, 전성비까지 개선하는 훌륭한 아이디어인 셈이다.

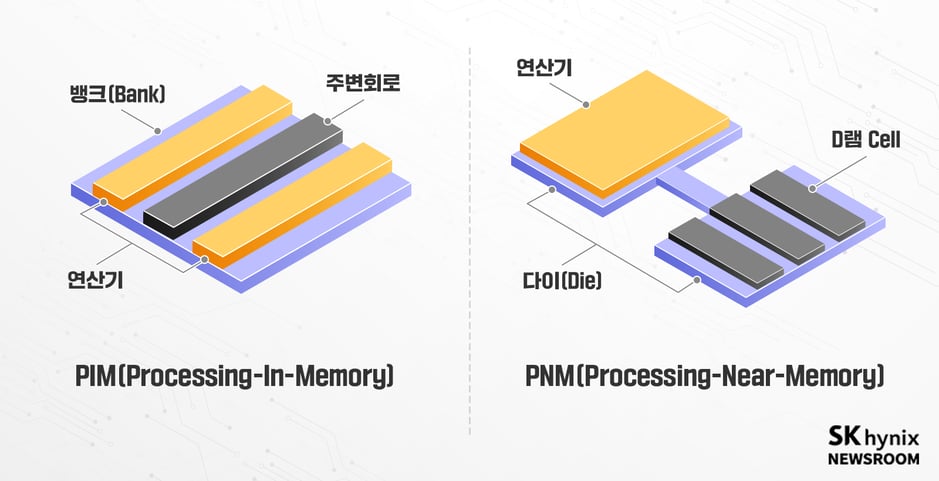

반도체 설계 관점에서 보면, PIM은 두 가지 방법으로 만들 수 있다. 첫째는 기존 D램 칩 내부에 연산기를 탑재하는 방식이고, 둘째는 D램과 매우 가까운 곳에 별도의 논리연산을 수행하는 칩을 배치하는 것이다. 전자는 D램 칩의 면적이 넓어지지만, 용량에 비례해 자동으로 연산 속도가 올라가는 장점이 있고, 후자는 로직 칩이 동반되어 메모리 반도체 회사 입장에서는 큰 비용을 들이지 않고 탑재 가능한 장점이 있다. 엄밀하게는 후자는 PNM(Processing-Near-Memory)이라 부른다. 연산 장치가 메모리 반도체에 가까이 있을 뿐, 별도의 칩에 있기 때문이다.

이런 메모리는 인공지능 개발사와 인공지능을 활용하는 서비스 회사 모두에게 매우 큰 이점을 준다. 인공지능 개발사는 현재 자신의 회사가 개발 중인 인공지능에 활용할 데이터는 충분하지만, 학습 속도가 느릴 때 PIM과 같은 솔루션을 도입함으로써 학습 속도를 크게 개선할 수 있다. 만약 인공지능 시장이 거대 신경망을 자주 학습시켜야 하는 방향으로 진화한다면, PIM은 매우 매력적인 솔루션이 될 것이다. 인공지능을 도입해 서비스하는 회사들에게 운용 비용 감소의 이점을 제공할 수 있기 때문이다. 또한, 전력 대비 성능이 높기에 전기를 적게 쓸 뿐만 아니라, 더 적은 개수의 GPU가 탑재된 서버로도 동일한 수준의 서비스를 제공할 수 있어, 공간에 대한 임대료도 낮아지게 된다.

뿐만 아니라, PIM과 같은 솔루션은 GPU 이외의 반도체를 인공지능 시장에 끌어들일 수 있을 것이다. CPU의 경우, 조건에 맞춰 선택지를 택하는 각종 분기 처리 등을 향상하기 위해 총 연산 능력을 줄였는데 PIM이 도입되면 그 단점을 상쇄시키는 동시에 CPU의 장점 또한 유지할 수 있다.

메모리 회사의 유망한 미래 사업

PIM은 메모리 반도체 회사 입장에서 매우 훌륭한 미래 시장이 될 수 있다. PIM이 탑재되어도 메모리 반도체의 사용량은 줄지 않기 때문이다. 예를 들어, PIM이 탑재된 시스템에서 작동되는 특정 인공지능이 1만 개 이미지를 처리해야 한다고 해도 메모리는 여전히 1만 개의 이미지가 들어갈 용량이 확보돼야 한다. PIM은 연산의 효율을 높여주는 것이지, 1만 개의 이미지 필요량을 5,000개로 줄이지는 않기 때문이다. PIM으로 인해 더 빠른 연산이 가능해지면서, 메모리 반도체 회사들은 더 많은 용량의 메모리를 생산해야 되는 상황이다.

다만, PIM을 사용하기 위해서는 기존의 소프트웨어를 고쳐야 한다는 장애물이 있다. PIM이 존재하지 않던 시절의 소프트웨어들은 연산을 위해 다음의 과정을 거칠 수밖에 없다.

메모리에서 값을 읽어 온다.

→ 읽어온 값을 연산 칩이 처리한다.

→ 다시 메모리에 적는다.

이런 연산 과정을 가진 소프트웨어 기반의 컴퓨터에 아무리 PIM을 적용해도 기존 소프트웨어들은 어떤 장점도 얻을 수 없다. PIM을 통한 장점을 활용하기 위해서는 다음의 형태로 프로그램을 고쳐야만 한다.

PIM으로 연산 명령을 보낸다.

→ PIM의 처리 결과를 확인한다.

이러한 입장을 이해해야만 PIM의 잠재력을 온전히 보여줄 수 있다. 아직 많은 소프트웨어 회사들은 PIM을 잘 이해하지 못한다. 이 때문에 PIM의 잠재력을 100% 보여주고, 고객의 마음을 사로잡기 위해서는, 메모리 반도체 회사가 소프트웨어의 입장을 이해해야 하는 시대가 된 것이다.

인공지능의 시대, ‘PIM’이 핵심

인공지능 시대가 도래하면서 데이터를 이용해 수많은 연산을 해야 하는 상황이 됐다. 데이터를 저장하고 운송하는 주체가 메모리 반도체인 이상, 인공지능 시대는 메모리 반도체 회사에 엄청난 기회가 되고 있다.

하지만, 이 기회는 공짜가 아님을 유념해야 한다. 메모리 회사 앞에는 메모리의 큰 고객인 GPU, CPU 칩 메이커들을 비롯해, 최고의 효율을 뽑아내고 싶어 하는 클라우드 고객들, 수많은 인공지능 알고리즘 연구개발, 인공지능을 활용한 서비스 제공 기업 등 다양한 이해관계자들이 존재한다.

PIM은 단순한 메모리 반도체가 아니기 때문에 앞에서 언급한 이해관계자들과 단편적인 관계를 맺을 순 없다. PIM의 판매량이 늘어날수록 이해관계자들과의 관계는 새롭게 구축될 것이다. 고객이었던 상대가 어느 순간 경쟁자가 되기도 하고, 직접적인 관계가 없던 상대가 가장 중요한 고객이 될 수도 있다.

이러한 변화에서 PIM이 고객들에게 더 큰 호응을 얻기 위해선, 고객의 입장이 돼야 한다. 단순한 제품이 아니기에 이론상의 최대 성능에만 집중해선 안 된다. 실제로 고객들이 SK하이닉스의 PIM과 PNM 제품을 사용했을 때 얼마나 큰 효용을 얻는지가 중요해질 것이다. 특히 단순한 메모리가 아닌 만큼 예상치 못한 문제가 발생했을 때 얼마나 빠르게 해결할 수 있는지도 중요하다. 결과적으로, 완전히 새로운 아이디어인 PIM과 PNM 제품이 확실한 효용 증대를 불러오고 큰 불편함이 없다는 것이 증명될수록 고객들은 기꺼이 PIM과 PNM 제품을 도입할 것이다.

고객들은 전성비가 10% 나빠지고, 가격이 10% 비싸져도 새로운 칩을 도입했을 때 기존에 고민했던 문제를 빠르게 해결할 수 있다면 기꺼이 도입할 것이다. 결과적으로 새로운 비즈니스가 아닌 기존 고객과의 신뢰를 기반으로 변화되는 요구사항을 만족시키는 혁신이 중요하다. 이런 면에서 SK하이닉스는 PIM과 PNM 제품을 출시하고 있는 상황이기에 미래가 더욱 기대된다.